参考了文章:

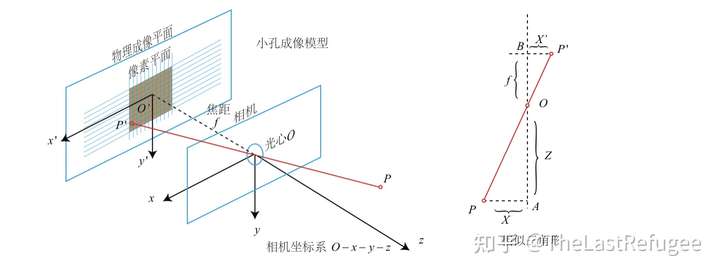

相机的内参和外参

相机内参

参考了文章:

来源:Bilibili

带翻译:https://www.bilibili.com/video/BV1A64y1v77W/?spm_id_from=333.788.b_7265636f5f6c697374.2

指的是列向量

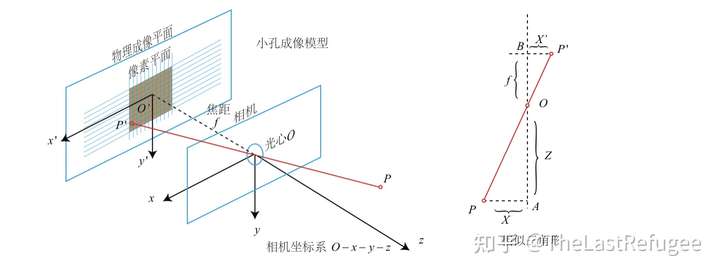

矩阵求导在最大似然问题中经常出现。总的来说,矩阵求导有四种类型,可以用下列表格表示:

一句话概括:分子的偏导符号根据\(\mathbf{Y}\)的形状展开,而分母的偏导符号根据\(\mathbf{X}\)的形状的转置展开。举例来说,\(\mathrm d \mathbf y / \mathrm{d} x\)是一个列向量,\(\mathrm{d} y / \mathrm{d} \mathbf{x}\)是一个行向量(假设\(\mathbf y\)和\(\mathbf x\)都指的是列向量)。每个积分都可以这样“冗长地”通过标量的偏导来计算,但是本节展示如何来通过矩阵操作来计算矩阵求导。

经过上次旁听小组会,大致对神经表示的方法有所了解,这是那次组会上张江辉分享的神经表示+超分辨的论文,当时没有太听明白,这回拿出来仔细研读一下。

这篇论文主要利用了神经表示在3D重构中的作用,提出了一个局部隐式图像函数(Local Implicit Image function, LIIF),利用表示的连续性完成任意尺度的超分辨。

这是一篇超分领域的知识蒸馏工作,发表于ECCV 2020

传统的CNN-based超分方法,一般需要大量的存储资源和计算资源,难以在移动设备以及一些没有神经处理单元和芯片外存储器的设备上运行。

也有很多工作是致力于减少神经网络的消耗的:

对于图像超分辨问题,最简单的方法是基于邻像素的空间不变性的双线性插值、双三次插值等方法,但是这些方法忽视了图像内容的多样性,会造成过于模糊的纹理结构与细节。

为了处理图像中的不同的内容,稀疏字典学习(sparse dictionary learning)独立地处理每个像素(或者patch)。比如经典的这篇《Image super-resolution via sparse representation》,给LR和HR中的patch学习一对字典,而假设LR和HR图像共享同一个稀疏编码。在推理过程中,给定训练字典,在一个优化过程中求出稀疏编码,从而完成对HR的估计。然而,在训练过程中,(字典与编码的)联合优化的难度还是会影响恢复效果。比如《Raisr: Rapid and accurate image super resolution》这篇中,基于图像的局部梯度统计特征,对图像的patch进行聚类处理,对每一类使用一个滤波器。虽然简单,但这种硬选择(hard-selection)操作是不连续的且不可微的。它们只为变化的输入模式提供折衷的解决方案,而不是最优的解决方案。

而之后,各类深度学习的方法被提出来,但是挑战在于图像内容的无约束性质,当随机梯度存在很大变化时,训练可能是不稳定的。它会导致artifact。残差学习、注意力机制等策略可以缓解这些问题,但这些方法对计算资源要求很高。

与对原图像的直接估计不同,自适应滤波器(核)方法按照空间变化,对相邻像素进行分组。由此带来的好处有两点:

本文作者提出了一种,对SISR问题进行线性约束的方法——LAPAR(linearly-assembled pixel-adaptive regression network,线性组合像素自适应回归网络)。核心思想是,对一个进行把LR进行Bicubic插值后的模糊图像,应用一个“像素自适应”的滤波器进行滤波。而滤波器来自于,轻量级的卷积神经网络,这个网络根据每个输入像素,确定预定义的滤波器基的线性组合系数。

这篇文章把Transformer应用到low level视觉中,并且把多种low level视觉问题(去噪、超分辨、去雨)放在一起,设计一个预训练模型来统一解决这些问题。

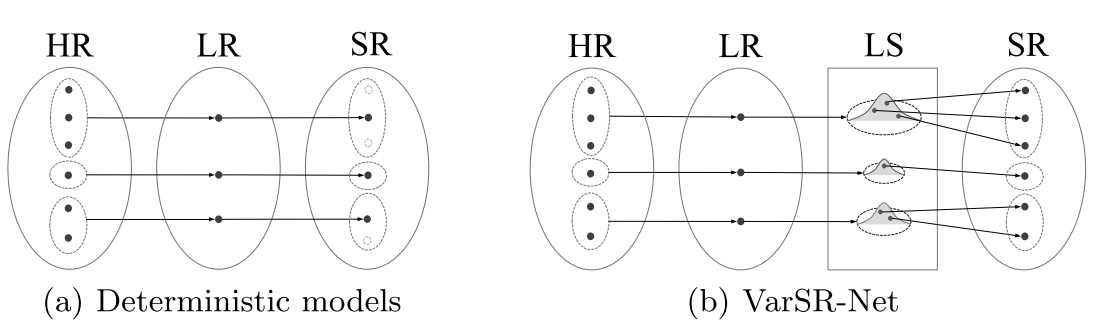

本文提出的方法要完成的任务是在超低分辨率下的超分辨,正视超分辨的ill-posed属性,从一张LR图像中恢复出多张可能的HR图像。这个方法被作者称为VarSR。

主要思路是:通过最小化在HR与LR的KL散度来连接LR图像与HR图像间的表示能力,从而把LR图像和HR图像同时encode到同一个隐变量特征空间。然后SR模块的输入是这个隐变量,生成一个与Ground-truth HR之间的像素/感知上的相似的SR结果。由于HR图像的多样性程度高于LR图像,因此HR图像的潜在变量要比LR图像密集得多。所以在推理过程中,从隐变量空间中多次取样,从而产生多种SR图像。整个过程如下图所示。

这里,作者照例总结了几个生成模型:

基于流的生成模型有如下的优点: